En este artículo se profundiza en el proceso de integración de modelos IA desarrollados por Aerotools, realizando la descripción detallada de un caso de éxito en aplicación real: el análisis de imágenes RGB de alta resolución capturadas desde dron, orientado a evaluar el estado de los módulos de una planta fotovoltaica del año 2006, con el objetivo de documentar y formalizar reclamaciones al fabricante para la sustitución de módulos aún cubiertos por garantía.

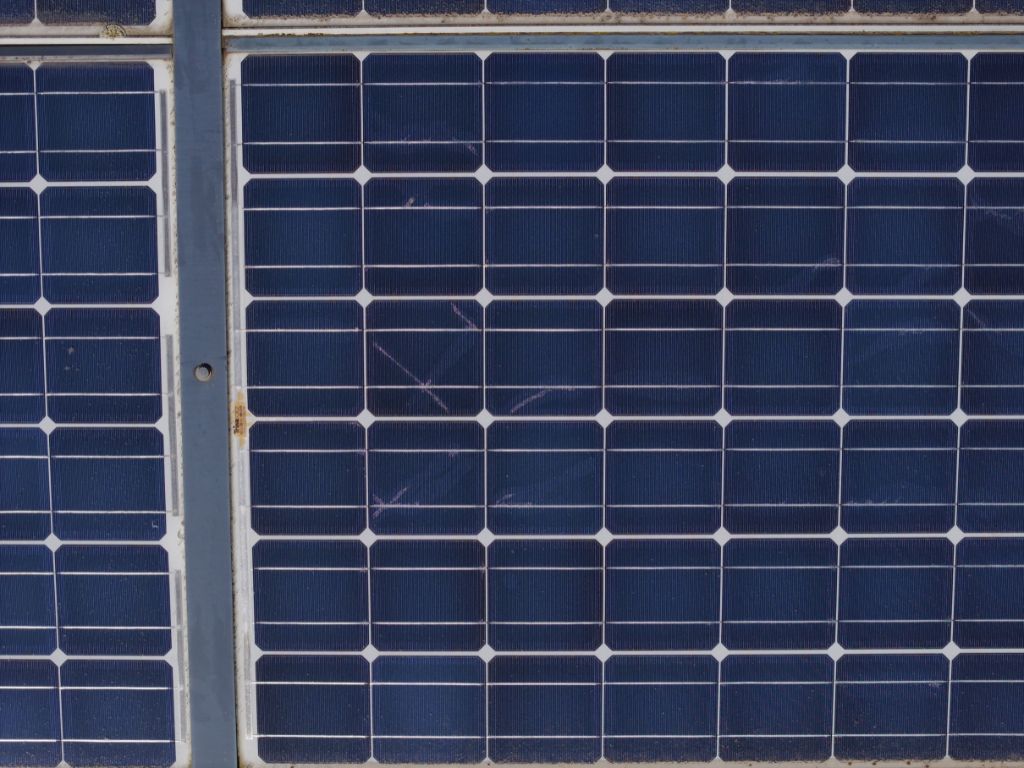

La inspección se centra en identificar módulos afectados por degradación del backsheet, cuyo deterioro permite la entrada de humedad y agua en el interior, provocando fallos de aislamiento, derivaciones, corrosión en las conexiones frontales, deslaminaciones en celdas y degradación prematura del módulo. La identificación de incidentes como corrosión en distintos grados o localizada en elementos metálicos como busbars o tab ribbons, así como la aparición de defectos como snail trail, cell framing o deslaminaciones superficiales, representan indicadores claros de daño estructural que pueden justificar la sustitución del módulo.

Las plantas de tamaño pequeño o medio tienen instalados entre 5.000 y 50.000 módulos, de los cuales se deben capturar imágenes con suficiente resolución, georreferenciarlas al módulo y posición exacta, leer el número de serie para garantizar la trazabilidad, ejecutar análisis automático de defectos e integrar evidencias comentadas para sustentar la reclamación ante el fabricante.

El caso de este ejemplo se planteó en varias fases, con objeto de atender los requerimientos del cliente.

Fase 1: Análisis de Busbar & Tab Ribbon

Los procesos de IA definidos para el análisis visual de la zona busbar para la detección de corrosión, requieren una cadena específica de preprocesamiento de las imágenes.

Los modelos utilizados en esta fase se basan en redes neuronales convolucionales (CNN, Convolutional Neural Networks), una arquitectura ampliamente utilizada en visión por computador gracias a su capacidad de extraer patrones espaciales relevantes. Cada planta requiere un entrenamiento específico adaptado a la tipología de módulos, calidad de las imágenes y variabilidad de las capturas.

Como primera etapa, se procede a la extracción de etiquetas correspondientes a los números de serie, que servirán posteriormente para generar las imágenes de busbar que se analizarán en una línea de proceso independiente. La lectura de números de serie constituye un proceso autónomo basado en IA, previamente tratado en otros artículos, y cuyo éxito depende en gran medida de la validación de los resultados generados por el modelo. Para ello, contar con el Flash Report del fabricante resulta fundamental, ya que acelera la verificación y aumenta su fiabilidad.

El proceso es iterativo: una vez obtenidos resultados preliminares, se valida, se corrigen errores y se reentrena el modelo. El volumen total de imágenes —más de 50.000 capturas de alta resolución— implica tiempos de procesamiento prolongados. Las plataformas de entrenamiento presentan limitaciones en tamaño de imagen, número de épocas, disponibilidad de GPU y estabilidad de ejecución, pudiendo interrumpir procesos largos y obligando a repetirlos.

El concepto de épocas (=epochs) explica la dificultad: en IA, especialmente en entrenamiento de modelos de machine learning y redes neuronales, una epoch es una pasada completa del modelo por todo el conjunto de datos de entrenamiento; en cada epoch, el modelo ajusta sus parámetros (los “pesos”) aprendiendo de los errores cometidos; normalmente se necesitan varias epochs (decenas o cientos) para que el modelo converja y alcance un buen rendimiento).

Para evitar retrasos acumulados resulta imprescindible diseñar un procedimiento robusto y tolerante a fallos.

Otro elemento crítico son los criterios de validación aplicados en la detección de incidentes de corrosión, basados tanto en referencias técnicas del fabricante como en la experiencia de especialistas en inspección. Mantener criterios uniformes de evaluación constituye un factor clave para la consistencia del análisis.

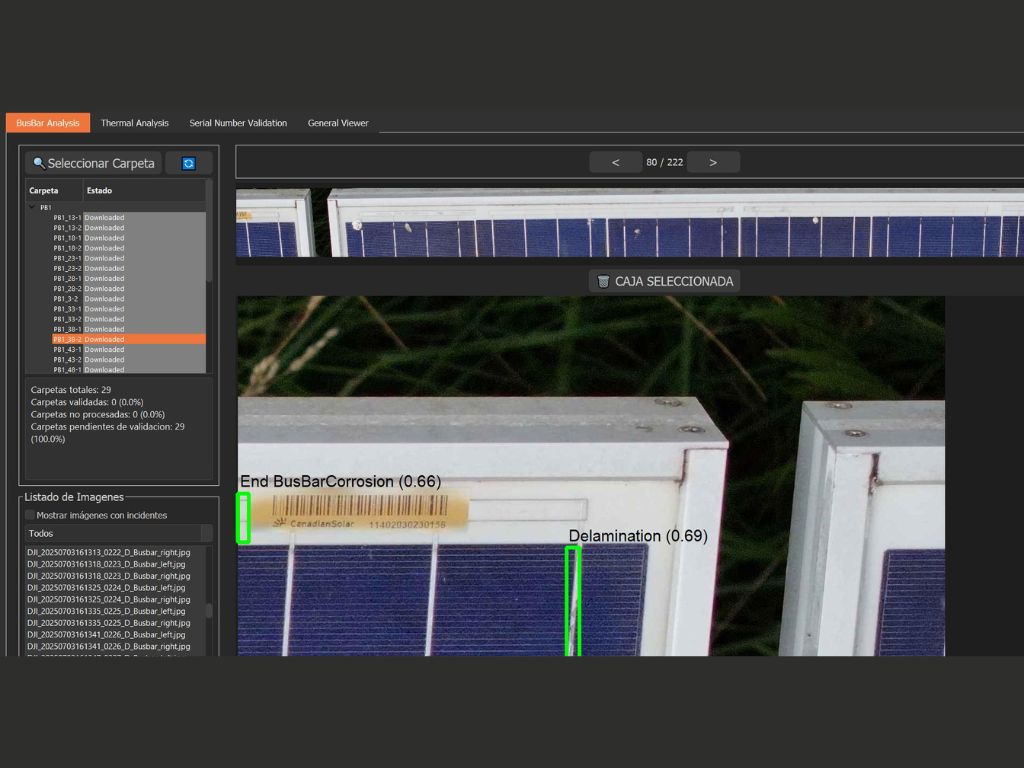

Para agilizar esta validación se ha desarrollado una interfaz específica que permite visualizar las imágenes junto con sus etiquetas de incidentes, corregir anotaciones y registrar los cambios en el formato adecuado para integrarlos posteriormente en el reentrenamiento del modelo.

Los resultados de esta fase se ofrecen con imágenes etiquetadas de módulos con incidentes caracterizados (corrosión en sus diferentes formas y grados de evolución…).

Fase 2: Análisis de Snail Trail & Cell Framing

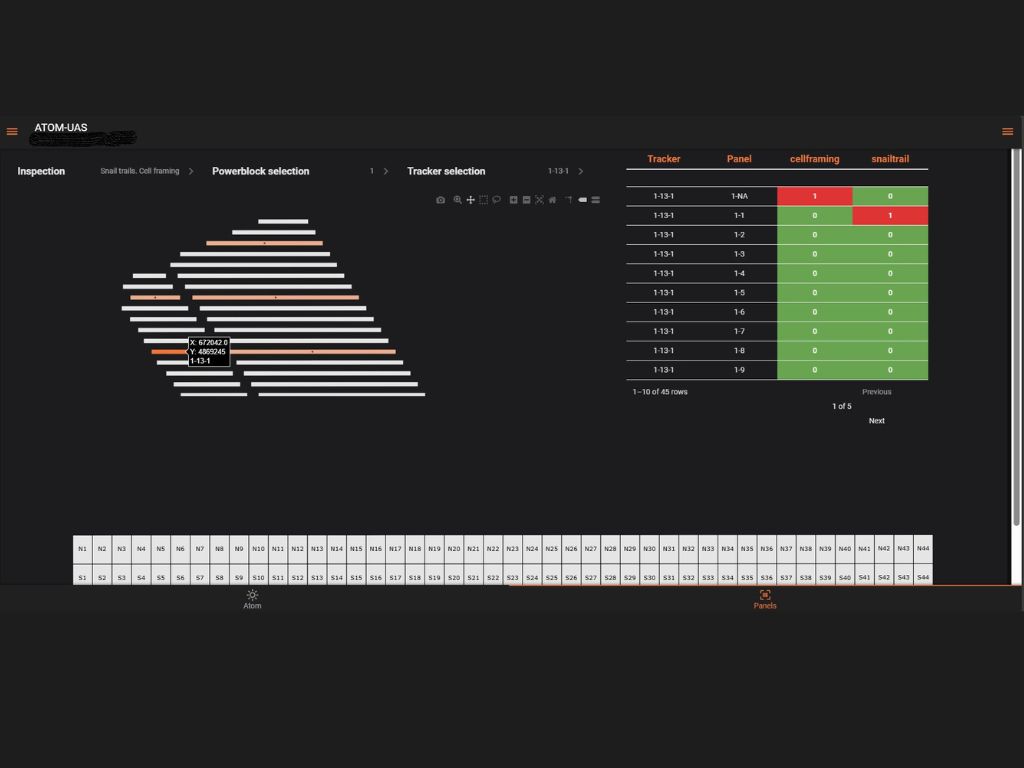

En la segunda fase se amplía el análisis a zonas extendidas del módulo, utilizando imágenes de mayor cobertura donde se pueden identificar fenómenos como Snail Trail, Cell Framing o defectos en Tab Ribbon. Este cambio representa un aumento significativo del alcance respecto a la fase 1. Debido al incremento de tamaño de las imágenes y de la carga computacional asociada, se decide adoptar un enfoque de IA distinto, basado en modelos VLM (Visual Language Models).

Los VLM, evolución multimodal de los LLM (Modelos de Lenguaje de gran tamaño), combinan análisis de imagen y capacidad de razonamiento textual. El modelo aplicado se complementa con técnicas RAG (Retrieval-Augmented Generation) y con un prompting refinado que define de forma precisa los incidentes a identificar. Este enfoque no etiqueta la ubicación exacta del defecto, pero sí determina qué imágenes presentan el incidente, lo que permiten una categorización suficiente del módulo.

En IA, especialmente en modelos de lenguaje (LLM) o modelos visual-lingüísticos (VLM), un prompt es la instrucción o entrada que se le da al modelo para indicarle qué debe hacer. Es, básicamente, el texto (o texto + imagen) que guía la respuesta del sistema.

En lo que se refiere al RAG, se trata de una técnica que combina búsqueda de información con modelos generativos, que busca primero la Recuperación (Retrieval) en una base de datos, documentos o repositorio aquellos textos que son relevantes para la consulta del usuario; y en una segunda fase Generación (Generation), utilizando esa información recuperada para generar una respuesta más precisa, actualizada y basada en datos verificables.

La práctica demuestra que un único prompt no es suficiente para detectar de manera fiable varios tipos de incidente en la misma imagen y de forma simultánea, obligando a generar prompts e inferencias separadas, lo que multiplica la carga de trabajo y los tiempos de proceso.

A ello se suma la dificultad que supone el gestionar imágenes de gran tamaño (un incremento cercano a un factor 10 respecto a la fase 1), lo que provoca interrupciones reiteradas en los entrenamientos debido a sobrecarga de servidor o fallos en las herramientas del proveedor.

En todo el proceso, es muy importante tener en cuenta y ajustar en todo momento aspectos como:

- Tiempos de carga y descarga de imágenes

- Tiempos de procesamiento

- Capacidad computacional requerida

- Elección del modelo de IA

- Coste de recursos

- Definición de la sistemática de inferencia para la detección confiable de imágenes con incidentes (selección y refinado de prompts, elaboración de RAG o validación de resultados).

En esta caso de éxito, se analizaron todas las imágenes capturadas de la planta, revisadas y clasificadas, asignando “1” a las que presentan incidente y “0” a las que no lo presentan, para cada tipo de defecto definido, ofreciéndose evidencias de dichos incidentes en el entorno ATOM (web, informes) con objeto de documentar la reclamación para cada módulo que presenta incidente: Número de Serie con imagen de la etiqueta, imágenes etiquetadas con defectos localizados en la inspección de Fase 1 e identificación de las imágenes con defectos en Fase 2.

Como resultado final, se procesaron más de 50.000 imágenes de la planta y se finalizó el análisis en 3 semana de trabajo, con resultados muy satisfactorios para Números de Serie (por encima del 98% de éxito), del 75% en imágenes con Busbar & Tab Ribbon y Snail Trail, y algo menos para imágenes con Cell Framing, en torno al 70%, algo esperable debido a la naturaleza más difusa y compleja de este último tipo de defecto. Como conclusión, se continúa trabajando en aumentar las iteraciones de Fase 1 y Fase 2, así como en refinar los procesos de validación, con objeto de mejorar los modelos y consolidar todo el proceso.

Artículo escrito por:

Miguel Rosa

(CEO) y técnicos del equipo de

Aerotools